Wir planen und bauen ihr Kraftwerk der Zukunft

Innovation-Planung-Projektierung-Systemintegration-Inbetriebnahme-System-Remote-Control-Center 4.0

Brennstoffzellen-ORC-Turbinen-Systemtechnik 1.65 MW elektrische Anschlussleistung

Erzeugungskapazität elektrisch 8700 Bh a BZKW-ORC-Turbinen-System 14.355.000 kWh

Erzeugungskapazität thermisch 8700 Bh a BZKW-ORC-Turbinen-System 6.500.000 kWh

Skalierbare Leistungsklassen 400 kWel- 20 MWel

Hohe Grundlast-Effizienz

Energieträger Erdgas/Biomethan

Kosten Energieeinsatz ca. 30% vs. konventioneller Erzeugung

Nahezu Schadstofffreie- und saubere Energieerzeugung

Extrem hoher bisher nicht erreichter Wirkungsgrad durch ORC-Turbinen-Systemkopplung

Vorausschauende Betriebsführung, Wartung, Revision des vernetzten Systems über 4.0 Remote-Control-Center

Amortisation unter Einbeziehung von Fördergeldern ca. 2 Jahre

Innovation-Ablaufplanung-Konzept-Entwurf-Definition-Umsetzung

Grundlagenermittlung im Bestand und Konzeptentwurf

Definition der Aufgabenstellung und grundlegender Anforderungen

Ermitteln der Planungsrandbedingungen

Beratung im Leistungsbedarf gegebenenfalls zur technischen Erschließung und Erfassung wesentlicher Voraussetzungen

Exakte Berechnung der Wirtschaftlichkeit und Amortisation unterschiedlicher Auslegungen

Zusammenfassen, Erläutern und Dokumentieren der Ergebnisse

Vorplanung

Konzeptionen der technischen Lösungen

Abstimmung, Kostenrahmen und Kostenschätzung

Wirtschaftlichkeitsuntersuchungen und Berechnungen

Entwurfsplanung

System-und Integrationsplanung

Technische Beschreibung der geplanten Lösungen

Investitions-Kostenberechnung der potentiell unterschiedlichen Auslegungen

Genehmigungsplanung

Bearbeiten aller Fördermöglichkeiten

Abstimmung mit Sondergutachten

Ausarbeiten aller Vorlagen für notwendige Genehmigungen und Anträge

Ausführungsplanung

Erarbeiten der Ausführung innovativer Planungslösungen

Feinkoordinierung aller Gewerke

Koordination der Ablaufprozesse

Ausarbeiten der Leistungsbeschreibung

Inbetriebnahme

Betriebsführung Remote Control Center 4.0

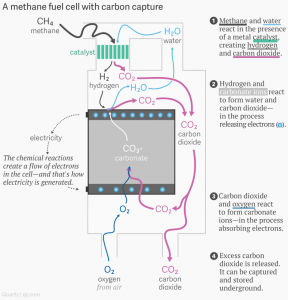

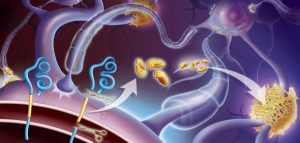

Carbon Capture and Utilization (CCU) mit Molten Carbonate Fuel Cell MCFC/ Schmelzcarbonat-Brennstoffzellen

Der im folgenden abgebildete Prozess stellt den Ablauf dar, wie aus der Umgebungsluft des Standortes der Anlage, der Sauerstoff

in einer elektrochemischen Reaktion zu Wasserstoff umgewandelt wird.

In diesem Prozess wird auch ein bestimmter Anteil des darin enthaltenen CO² verarbeitet, der in diesem Procedere´ als

Endprodukt, neben der Bereitstellung von elektrisch- thermischer Energie, auch Wasserstoff als extern nutzbaren Überschuss

generiert.

Dienstag, 07.08.2018

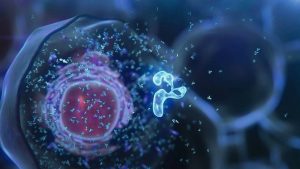

Quantencomputer Kernmodul-C-Animation („Qubits“)

Quantencomputer als neuer Maßstab der Datenwelt- und KI-Betriebsführung von Energie-

Erzeugungsanlagen

Anfang der 1980er Jahre kam die Idee auf, einen Computer zu konstruieren, der nicht nur die beiden Werte 0 und 1 annehmen

kann, wie das bei herkömmlichen Bits der Fall ist, sondern auch gewissermaßen jeden Wert dazwischen.

Mit einem solchen System lässt sich die Rechenleistung explosiv steigern.

Um solche Qubit-Systeme zu realisieren, benötigt man quantenmechanische Zweizustandssysteme.

Das sind Systeme, die sich nicht nur in einem ihrer beiden Zustände befinden, sondern in beliebigen Überlagerungen , auch Super-

Positionen genannt werden. Ein Beispiel dafür ist der Spin eines Elektrons, ein anderes die Energieniveaus von Atomen und

Molekülen.

Hierbei ist das knifflige, dass sich solche Quantensysteme nur sehr schwer kontrollieren lassen und darüber hinaus muss man für

sinnvolle Anwendungen viele solcher Qubits verschalten.

Am MIT (Massachusetts Institute of Technologie) scheint jetzt der Durchbruch gelungen zu sein und erste größere

Quantencomputer werden derzeit gebaut bzw. befinden sich in den jeweiligen Testphasen.

Allerdings lösen solche Prototypen bisher nur sehr spezielle Probleme, normale Rechner können sie aktuell noch nicht so richtig

ersetzen.

Für potentielle KI-Systeme werden sie allerdings den wahrlich größten Quantensprung, im wahrsten Sinne des Wortes realisieren

und damit epochale Veränderungen im Bereich künstlicher Intelligenz, die den diesbezüglichen Hype und der Euphorie in diesem

Zusammenhang noch mehr Anreize geben wird.

Die empirischen Belege für eine Wissensexplosion dafür sind zwar noch dünn, aber der Strom an Daten und Befunden,

die aus den Laboren an die Öffentlichkeit dringen machen Hoffnung, das die Zukunft doch nicht ganz so schwarz aussieht wie

sie in einem bestimmten Mainstream oft postuliert wird.

Diese Erkenntnis sagt uns, dass hinter den einfachen linearen Verkettungen in der Natur, ein komplexes hochdynamisches und für

Überraschungen immer wieder gutes Netzwerk steckt, das für sein Funktionieren viele Mitspieler braucht.

Angefangen von dem Mikrobiom unserer Daseinsebene bis zu den Galaxien und Dimensionalitäten des Universums, werden die

Fundamente der menschlichen Kognition immer wieder neu erschüttert werden.

Mittwoch, 25.07.2018

Demographisch-KI-inspirierter Wandel und die Erosion der Mittelschicht

In einigen Jahren wird es nur noch eine Ober-und Unterschicht geben.

Eine Analyse zeichnet ein düsteres Bild der Zukunft in den Industrieländern.

Volkswirtschaften formen sich durch Alterung und Automatisierung neu. Im Extremfall wandelt sich das Drei-Klassen-Modell

in ein Zweiersystem-mit 80 Prozent Unterschicht.

Wiederholt sich die Geschichte doch? Die 20er-Jahre dieses Jahrhunderts bieten nach einer umfassenden Analyse der

amerikanischen Managementberatung Bain alle Voraussetzungen, um zu einem ausgewachsenen Krisenjahrzehnt zu werden,

ähnlich wie das wilde Jahrzehnt 100 Jahre zuvor.

„Die 2020er-Jahre werden zu einer Dekade der Extreme“, sind sich die Berater sicher.

Damit verbinden sie zwar keine Aussage über mögliche politische und militärische Katastrophen, in die die turbulenten

20er-Jahre des abgelaufenen Jahrhunderts schließlich mündeten-in Deutschland machten sie Hitler möglich.

Doch die Aussichten klingen auch so düster genug. „Über den Industriestaaten braut sich ein Sturm zusammen“,

heißt es.

Drei absehbare Trends bündeln sich nach Einschätzung der Autoren Karen Harris, Austin Kimson und Andrew Schwedel

zu einem unheilvollen Ganzen.

“ Die Automatisierung wird ganze Volkswirtschaften neu formen, die Arbeitsmärkte in Tumult versetzen und die

Spielregeln in vielen Wirtschaftszweigen verändern“, heißt es in der Studie. Gleichzeitig werde die Alterung der

Bevölkerung die Sozialsysteme strapazieren“ wie nie zuvor“.

Dazu kommen eine wachsende Ungleichheit bei Einkommen und Vermögen in den meisten Industrieländern-die Spanne

zwischen Gewinnern und Verlierern der Modernisierung wird größer, wobei die Gewinner deutlich in der Minderheit bleiben.

Diese Kräfte seien bereits heute dabei, ihre Wirkung zu entfalten.

Deutschland bildet in diesem Szenario nicht gerade eine Insel der Glückseligen, kommt aber nach Einschätzung der Auguren

vergleichsweise glimpflich davon. Hauptgrund: Die deutsche Industrie liefere (noch) einen Großteil der technischen

Ausrüstung zur Modernisierung der Weltwirtschaft.

Doch auch in Deutschland profitierten nur diejenigen von der Digitalisierung, die über genau passende Qualifikationen

für die künftigen Herausforderungen verfügten. Dies treffe etwa auf jeden fünften Berufstätigen zu.

„Während ihre Gehälter deutlich steigen, gerät die breite Mittelschicht in der kommenden Dekade immer stärker unter Druck“,

erwartet Bains Deutschland-Chef Walter Sinn.

Wie die Modernisierung sich schon in wenigen Jahren auf den Alltag der Konsumenten auswirken kann, dafür nennen die

Berater etliche Beispiele.

Amazons Umwälzungen im Handel seien nur ein zarter Vorgeschmack auf revolutionäre Entwicklungen in vielen weiteren

Branchen, wie Energieversorgung, Gesundheitswesen, oder Luftfahrt. Überall werde es Pioniere geben, die die

Digitalisierung für völlig neue Anwendungen und Angebote nutzten.

Autonomer Verkehr werde die Stadtplaner zu einem grundlegenden Umdenken zwingen. Heute von Parkplätzen

beanspruchter Raum werde frei, weil smarte Autos Pendler und Shopper einfach am Ziel absetzen und sich dann anderswo

nützlich machen würden.

Und in der Gastronomie erreiche die Automatisierung ein neues Level.

Roboterisierte Zubereitungssysteme könnten Kundenkontakte und Logistik revolutionieren.

Auf den Arbeitsmärkten wird es laut Studie turbulent zugehen.

„Zu Beginn der 20er-Jahre werden Arbeitskräfte zur Mangelware“, erwartet Sinn.

Schon jetzt ist der Mangel an talentierten Fachkräften allenthalben spürbar. Später aber werde die Zahl der Arbeitskräfte in der

Automatisierungswelle in den USA nur noch geringfügig steigen und in Europa sogar sinken, wobei die Auswirkungen auf den

Einzelnen laut der Studie hier milder ausfallen könnten:

In westeuropäischen Ländern wie Skandinavien, Deutschland und Frankreich könnten das stärkere soziale Netz und

vergleichsweise regulierte Arbeitsmärkte dazu führen, dass Investitionen in die Automatisierung langsamer vorgenommen werden.

Überall in den westlichen Ländern werde die Entwicklung aber zu einer Erosion der Mittelschicht führen, in den USA besonders

drastisch. Dort werde das herkömmliche Modell mit drei Einkommensklassen-Unter-,Mittel- und Oberschicht der Verdiener-

sich in ein Zweiersystem umwandeln.

Auf der einen Seite Wohlhabende, die etwa 20 Prozent der Bevölkerung ausmachten, auf der anderen Seite die übrigen 80 Prozent,

deren Einkommen unterhalb des Niveaus der heutigen Mittelschicht rangieren dürften.

Insgesamt bilde die Schrumpfung der Mittelschicht eine Bremse für das künftige Wirtschaftswachstum, welches im übrigen

noch durch Ressourcenknappheit und dementsprechende Verteilungskämpfe kaum noch Wachstum generieren kann.

Die wirtschaftlichen Spannungen in Kombination mit der Überalterung der Gesellschaft in vielen Ländern und einer starken

weltweiten Migration in diesem Zusammenhang, werde letztlich zu einem Gegeneinander der Generationen führen.

„Irgendwann jenseits des Zeit-Horizonts dieses Berichtes , wird sich die Weltwirtschaft erholen“, lautet das einigermaßen

versöhnliche Fazit. „Arbeitskräfte werden neue Fähigkeiten entwickelt haben, die Produktivitätsgewinne werden größeren

Anteilen der Bevölkerung zugute kommen und neue Branchen werden aufblühen“.

Doch ob es so kommt oder ob die vorhergesagten Umbrüche die Geduld vieler Menschen überstrapazieren wie 100 Jahr zuvor,

wird sich erst noch zeigen müssen.

Über so eine lange Zeitspanne nach vorn zu schauen, sei schwierig, geben die Schreiber an anderer Stelle der Studie selbst zu.

Disruptive technisch-revolutionäre Entwicklungen, heute noch nicht ab-und einschätzbare Erkenntnisgewinne werden-

und können uns bei allen Versuchen die Zukunft realistisch einzuordnen, ohne Angst vor einem neuzeitlichen

Armageddon, auch positiv überraschen.

Freitag, 13.07.2018

Elektromobilität: Ausgebremst durch Rohstoffmangel?

Unterwasser-Explorations-Roboter Tandem–Satelliten-Messung ´Anomalien´ im Erdmagnetfeld vs. Exploration

In den nächsten Jahrzehnten sollen weltweit hunderte Millionen E-Autos auf die Straßen kommen.

Deren Antriebsbatterien benötigen gewaltige Mengen an Rohstoffen wie Lithium und Kobalt. Hier könnte es zu

Engpässen kommen.

Batterierecycling sollte bei der zukünftigen Rohstoffversorgung daher eine zentrale Rolle spielen.

Kritische Rohstoffe für Elektroautos

Für den flächendeckenden Umstieg von Verbrenner auf batteriebetriebene Fahrzeuge werden erhebliche Mengen an Lithium,

Kobalt und anderen Metallen benötigt.

Die geologischen Reserven von Schlüsselmaterialien für die Produktion von Lithium-Ionen -Batterien sind eigentlich groß genug,

um die globale Versorgung langfristig zu sichern,

Temporäre Verknappungen bestimmter Rohstoffe sind jedoch möglich.

Ausgediente Antriebsbatterien werden schon heute teilweise recycelt. Ein Ausbau der Anlagen zur Rückgewinnung kritischer

Elemente kann helfen, zukünftige Rohstoffengpässe zu vermeiden.

Schon 2015 lösten etwa Lithium-Ionen-Batterien die Keramik-und Glasbranche als Hauptanwendungsgebiet für Lithium ab.

Die Massenproduktion dieser Batterien bedarf großer Mengen an Schlüsselmaterialien, die sich nicht- oder nur bedingt ersetzen

lassen.

Aber liegen weltweit ausreichend Rohstoffe am Boden, um die Nachfrage der Autohersteller langfristig zu bedienen?

Neben der Verfügbarkeit spielen in der öffentlichen Debatte die ökologischen und sozialen Folgen der Rohstoffgewinnung eine

immer stärkere Rolle.

Denn die Grundstoffe leistungsfähiger Batterien stammen nicht selten aus Ländern, in denen niedrige Umweltstandards gelten;

bisweilen befeuert ihre Förderung sogar Gewaltkonflikte. Auch um Imageschäden zu vermeiden, dürften die Automobilhersteller

daher ein großes Interesse daran haben, ausgegliederte Lithium-Ionen-Batterien soweit wie möglich zu recyceln und kritische

Bestandteile wiederzuverwenden. In welchem Maße gelingt das bereits heute, und welchen Anteil an der Rohstoffversorgung kann

Batterierecycling zukünftig realistisch abdecken?

Allerdings ist bereits ein globaler Wettlauf um Rohstoffe massiv im Gange!

China reklamiert im Süd-Ost-pazifischen Sektor bereits (bisher) internationale Gewässer für sich; geringe Meerestiefen werden

durch Sand-Aufschüttungen zu Inseln erhöht und bereits militärisch abgesichert, obwohl die US-Navy dort nach wie vor

Präsenz zeigt.

Die Russen versuchen in Ihrem arktischen Einzugsbereich die ´Claims´ abzusichern und die US-Amerikaner erschließen von

Alaska andere Bereiche in der Arktis um dort diverse Rohstofflagerstätten zu erschließen- die Europäer sind diesbezüglich nach wie

vor im Tiefschlaf, obwohl Europa weltweit die geringsten Rohstoffreserven vorzuweisen hat.

Und last not but least versucht die NASA seit längerem Rohstoffe im Asteroidengürtel (das ist die `Gegend´zwischen Mars und Jupiter)

zu finden- und auf dem Mond und Mars erhofft man sich ebenfalls diesbezügliche Erfolge.

Mittwoch, 04.07.2018

Industriestrom: Strukturbrüche im Mittelspannungsnetz und starke Preissteigerung im 1. Halbjahr 2018

Bedingt durch immer auffälliger werdende Redispatch-Maßnahmen (Netzstabilisation) der Netzbetreiber, ist nicht nur der

Strom-Endpreis in der Niederspannung (Endverbraucher)- sondern auch der sogenannte Industrie-und Gewerbestrom in der

Mittelspannung im ersten Hj.18 stark angestiegen- und das wird vorerst auch so bleiben.

Der VIK-Strompreis-Index basiert auf den Strompreisen der EEX (European Energy Exchange und den Netznutzungsentgelten

der sechs großen deutschen Netzbetreiber.

Als Energiepreiskomponente liegen beiden VIK-Indizes die monatlichen Durchschnittspreise des Vormonates am EEX-

Terminmarkt für die kommenden noch handelbaren Quartalsprodukte zugrunde.

Base-und Peakloadanteile werden in Abhängigkeit von typischen Jahresbenutzungsstunden für Industriekunden

(3.000, 4.000, 5.000 und 6.000 h/a gewichtet.

Mit steigenden Jahresbenutzungsstunden steigt dabei auch der Baseloadanteil beispielsweise für 6.000 h/a auf 92% .

Der zweite gemeinsame Bestandteil beider VIK-Indizes sind die Netznutzungsentgelte der sechs Verteilnetzbetreiber,

Westnetz GmbH, Bayernwerk AG, Netze BW GmbH, Mitnetz-Strom GmbH, und Stromnetz Berlin GmbH für die Entnahme

aus der Mittelspannung (Netzebene 5) entsprechend den o.g. Benutzungsstunden.

Der VIK-Endpreisindex beinhaltet zusätzlich zu den o.g. Energie-und Netzkomponenten des VIK-Basisindex noch von

Industrieunternehmen üblicherweise zu zahlende gesetzliche Steuern, Abgaben und Umlagen.

Die Konzessionsabgabe (KA) für Sondervertragskunden fließt mit 1,1 €/MWh in den VIK-Endpreisindex ein.

Die KWK-G-Umlage sowie die §17f EnWG-Offshore-Umlage wurden entsprechend als reduzierte Umlage der Letztverbraucher

(Kategorie B LV Kat. B) mit 0,5 €/ MWh angenommen. Die Umlage für abschaltbare Lasten nach § 18 AbLaV wird ab dem Jahr

2014 mit 0,09 € /MWh berücksichtigt.

Der Anteil der Stromsteuer ist entsprechend dem Stromsteuerspitzenausgleich unternehmensindividuell.

Für den VIK-Endpreisindex wird ab dem Jahr 2014 ein Selbstbehalt von 20% (4,306 € /MWh) angenommen.

Die EEG-Umlage wird in voller Höhe 62,40 € /MWh-2014 berücksichtigt, da über die Hälfte des von der Industrie verbrauchten

Stroms-insbesondere aus der Mittelspannung nicht unter die besondere Ausgleichsregelung gem. § 64 EEG fällt und somit nicht

reduziert ist.

Bedingt durch die immer größer- und damit kostenintensiver werdenden Netzstabilisierungsmaßnahmen (Dispatch/Redispatch)

wird sich diese Situation erst ab Anfang der 2030iger Jahre wesentlich entspannen.

Jetzt wissen Sie warum bei uns die Energiekosten europaweit am höchsten sind und-wie schon mehrfach von uns thematisiert-

die gesicherte Eigenerzeugung nach wie vor die Ultima Ratio in Deutschland sein sollte.

Donnerstag, 28.06.2018

Dunkel gekennzeichnete Gebiete potentiell durch Überflutung in den nächsten Dekaden gefährdet

Prognosen globaler Langfristtrends

„Die Zukunft wird überraschend anders sein“, sagt Michael Lauster, Leiter des Fraunhofer-Instituts für Naturwissenschaftlich-

Technische Trendanalysen (INT).

Prognosen zu treffen, ist nicht immer einfach: Zu viele Faktoren beeinflussen Vorhersagen, neue Erfindungen sorgen für teils

signifikante Änderungen. Für den Zukunftsforscher ist es angesichts globaler Megatrends wichtig, dass Technologieentwicklung

eine übergeordnete Zielvorgabe hat.

Aktuell haben drei globale Langfristtrends nach seiner Meinung Priorität, die derzeit die Technologieentwicklung bilden:

Bevölkerungsentwicklung, Klimawandel und Urbanisierung.

Geografischer Hotspot all dieser Trends sei Afrika, so Lauster im Rahmen eines Vortrages an der Hochschule Bonn-Rhein-Sieg.

Klar sei: Die Temperaturen würden weiter steigen- mit besonderen Auswirkungen auf den afrikanischen Raum. Bis zum

Jahr 2100 rechneten Forscher mit lokalen Temperaturanstiegen von bis zu 7° C .

Gleichzeitig könnten sich dort die Niederschläge um bis zur Hälfte verringern.

Auch das Bevölkerungswachstum skizziert der Wissenschaftler: Wegen steigender Lebenserwartung und der jetzt schon hohen

Geburtenrate werden 2050 rund 10 Mrd. Menschen auf der Erde leben.

Der dritte sichere Trend sei die Urbanisierung. Während es derzeit 23 Megastädte mit mehr als 10 Mio. Bewohnern gebe, sollen es

2050 bereit 50 sein, so der Ingenieur, der an der RWTH Aachen den Lehrstuhl für Technologieanalyse und- Prognose innehat.

Alle drei „Phänomene“ werden bald für völkerwanderungsähnliche Situationen sorgen, ist sich der Zukunftsforscher sicher- und dass

ist eigentlich nichts Neues: Anfang der 1970iger Jahre gab es bereits Prognosen, die damals in Filmen und Literatur die

Migration aus Afrika nach Europa dargestellt haben, die heute zur Realität geworden ist.

Wissenschaftliche Tatsache ist heute, dass sich die Situation so weit zuspitzen wird, dass weltweit rund 200 Mio. bis

1 Mrd. Menschen aufgrund akuter Hungersnöte und Wassermangel eine neue Heimat suchen.

Aber auch das Internet trage eine Mitschuld. So sorge die dort gezeigte westliche Lebensart für Hoffnungslosigkeit in jenen

Ländern, denen es nicht so gut gehe.

Technik für die Zukunft muss dem Gemeinwohl dienen.

Zur Vermeidung einer riesigen Flucht durch Ressourcenknappheit und Perspektivlosigkeit diskutiert Lauster drei

Handlungsvorschläge für Europa:

Der Kontinent könnte das Problem einfach aussitzen, wobei bereits jetzt erkennbar ist, dass die Migrationsrouten ohne

Hilfe der dortigen Staaten nicht zu schließen sind. Alternativ ist der dritte Lösungsvorschlag erklärt Lauster:

Wir müssen verhindern, dass sich die Menschen überhaupt erst auf den Weg machen und vor Ort helfen, was man in

geringem Maß ja bereits tut.

Die Welt ist aber mittlerweile so verwoben, dass es kein Utopia auf der Grundlage einer einzigen Nation oder sogar

Kontinents geben kann.

Der kurz-und mittelfristige globale Anpassungsbedarf ist überall groß und variiert in den Bereichen große Trockenheit und

gewaltige Überschwemmungen an den Küsten und Flussläufen.

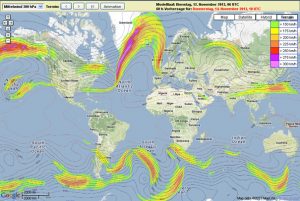

In der nördlichen Hemisphäre kommen noch langandauernde Hitze-und Kältewellen durch Veränderung der Ausbuchtungen

des Jet-Stream hinzu, die derzeit noch nicht im Handlungsspektrum der Länder enthalten sind.

Für die nächsten zwei, drei Dekaden weiß man zwar genau abzuschätzen was zu tun ist und dass wird sich auch dann

nicht ändern, wenn die avancierten Klimaschutzmaßnahmen doch noch greifen sollten.

Hochwasserschutzmaßnahmen werden vom Deichausbau bis zu veränderten Baustandards und Siedlungsverlagerungen

bereits eingeleitet.

Montag, 18.06.2018

BZKW 800 kW el 520 kW th

Investitionsschwäche in Europa-insbesondere in Deutschland

Deutschland muss bis 2025 rund 1,4 Billionen Euro investieren, um versäumte Ausgaben aufzuholen.

Ohne zusätzliche Investitionen sei das Wachstum gefährdet, heißt es in einer Studie: In allen fünf untersuchten Wachstumskategorien

gehört Deutschland nur zum Mittelfeld, bei der digitalen Infrastruktur landet die Bundesrepublik nur auf Platz elf.

In Deutschland wird zu wenig investiert- wodurch künftiges und nachhaltiges, der Umwelt verpflichtetes Wachstum in Gefahr ist.

Um in der Vergangenheit versäumte Investitionen wieder aufzuholen, müssten öffentliche und private Investoren zusammen jährlich hohe zusätzliche Milliardenbeträge investieren- 2025 insgesamt knapp 1,4 Billionen Euro zusätzlich. Das geht aus einer Studie der Prüfungs-und Beratungsgesellschaft EY hervor.

Bei jährlich steigenden zusätzlichen Investitionsausgaben würde 2025 der Höhepunkt mit zusätzlichen knapp 300 Milliarden Euro

erreicht. Das entspricht etwa 6-6.5 Prozent des deutschen Bruttoinlandsproduktes- ein Niveau, das danach beibehalten werden

sollte, heißt es in der Untersuchung:

Sollte Deutschland bis 2025 nur auf den Investitionsstand aus der Zeit vor der Finanzkrise zurückkehren, müssten die zusätzlichen

Investitionsausgaben bis 2025 immer noch um insgesamt knapp 815 Milliarden Euro steigen.

Will die Bundesrepublik in Europa auch weiterhin zur Spitze gehören, seien zusätzliche Investitionen nötig.

In keinem der für zukünftiges Wachstum wichtigen Investitionsfeldern Forschung, Digitalisierung, Basis-Infrastruktur,

Bildung und Gesundheit gehört Deutschland im europäischen Vergleich zur Spitzengruppe.

Am besten schneidet unser Land in der Kategorie Forschung, Innovation, und nachhaltige Energie mit Platz sechs ab-

am schlechtesten bei der Digitalisierung mit Platz elf.

Bei den übrigen Kategorien (Basis-Infrastruktur, Bildung, und Gesundheit) landet Deutschland auf den Rängen dazwischen.

„Deutschland hat es über die letzte Dekade versäumt, `zu Hause` zu investieren“, stellt Bernhard Lorentz, Partner bei EY, fest.

Das gilt sowohl für die öffentlichen Investitionen als auch für die privaten.

In der Folge hat die heimische Infrastruktur gelitten- und das betrifft nicht nur die digitale Infrastruktur wie Glasfaserkabel sondern

letztlich alle Bereiche, die für intelligentes, nachhaltiges und integratives Wachstum relevant sind.

Auffällig ist insbesondere, dass gerade die größten Volkswirtschaften Europas ausgerechnet bei der Digitalisierung vergleichsweise

schwach abschneiden. Neben Deutschland auf Platz elf geben auch Frankreich auf Platz 17 und Italien auf Platz 25 keine

gute Figur ab. Am besten schneidet Großbritannien auf Platz 6 ab.

Schweiz, Schweden, Niederlande und Dänemark sind die Top 4-, die letztgenannten gehören in allen Kategorien zu den Top 4

in Europa.

In der Kategorie gesicherte nachhaltige Energieerzeugung liegt Deutschland mittlerweile auf Platz 16 in Europa, wie heute im Rahmen des Rechenschaftsberichtes (Klimaziele) aus dem Bundesumweltministerium bekannt wurde.

Noch keine zweite Erde gefunden/ Hubble

Robotic: „Wachhund aus Boston“!

Mittwoch, 06.06.2018

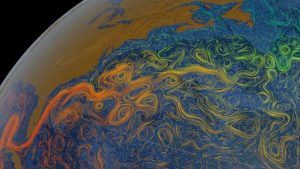

Klimatisch bedingte Verwirbelung im Golfstromsystem Nordatlantik US-Ostküste

Das Golfstrom-System wankt- und der Jetstream verlagert sich

Ein entscheidendes Element im Klimasystem, das in der Vergangenheit auch die Klimakatastrophen-Phantasien in Hollywood

beflügelt hat (“ The Day After Tomorrow“), liegt nicht weit weg von Grönland im Nordatlantik. In der Labrador-und Grönlandsee

ist das Kerngebiet des Golfstromsystems, das die „Atlantic Meridional Overturning Circulation“ (AMOC) antreibt

(früher Thermohaline Zirkulation) und mit Golfstrom plus Nordatlantikstrom unter anderem dafür sorgt, dass warme Wassermassen

aus den Tropen bis in den hohen Norden und nach Europa transportiert werden.

Unterhalb von Grönland sinkt das erkaltete-und deshalb dichtere Wasser in gewaltigen Strömungen in die Tiefe und

treibt ein globales Förderband von Meeresströmen an. Versiegt es, würde das einen klimatischen Dominoeffekt auslösen

und abrupte Temperaturveränderungen mit Langzeiteffekt zur Folge haben; wobei erste Auswirkungen bereits zu sehen sind.

Viele Jahre wurde unter Klimaforschern gestritten, ob dieses System kippen könnte, unter den lange noch zaghaften

Veränderungen im Ozean.

Levke Caesar vom Potsdam-Institut für Klimafolgen-Forschung und ihr Team haben jetzt in „Nature“ den gesuchten

„Fingerabdruck“ der Golfstromabschwächung beschrieben.

Die Verteilung von Erwärmung und Abkühlung der Wassermassen im Nordatlantik wird durch die Computermodelle der

Klimaerwärmung bestätigt.

Die Umwälzpumpe und die Ozeanzirkulation im Nordatlantik hat sich klar verlangsamt: um beachtliche 15 Prozent in nicht

einmal siebzig Jahren. Sie ist, das zeigt eine zweite „NATURE“-Publikation britischer Klimaforscher, schwächer als je

zuvor in den vergangenen tausend Jahren.

So radikal und eindeutig wurde dieser Wandel- abgesehen vom Potsdamer Golfstromexperten Stefan Rahmstorf, der das schon vor

Jahren so dargestellt hat und dafür auch als Alarmist beschimpft wurde-nur von wenigen Klimaforschern vorhergesagt.

Man muss schon schlucken, wenn Schellnhuber (ein anderer Klimaforscher) beim Vergleich mit dem größten Massensterben der

Erdgeschichte, an der Perm-Trias-Grenze,

als sich das Klima um fünf Grad erwärmte, nüchtern sagt: “ Das dauerte damals Zehntausende Jahre. Heute erwärmt sich die Erde

hundertmal so schnell. 90 Prozent aller marinen Arten sind damals ausgestorben, 70 Prozent der terrestrischen.

Die Biosphäre hat sich nach und nach komplett neu organisiert.

Was der Mensch heute anstellt, ähnelt eher dem Asteroideneinschlag an der Kreide-Paläogen-Grenze.

Dass so etwas jetzt geschieht, in diesem Tempo, auf einem übervölkerten, übernutzten Planeten, gleicht einem kollektiven

Suizidversuch.

Donnerstag, 24.05.2018

Hausse Rohstoffe-Zinsen-Dollar

Die amerikanische Notenbank (Federal Reserve) will bei anhaltend guten Konjunkturaussichten-und die werden gut bleiben-

die Zinszügel weiter anziehen.

Dies geht aus den gestern veröffentlichten Protokollen der FED-Zinssitzung von Anfang Mai hervor.

Demnach sind sich die meisten Währungshüter darin einig, dass ein solcher Schritt auf dem Weg zu einer weniger

konjunkturstimulierenden Geldpolitik bald erforderlich sein dürfte.

Die Investoren an den Märkten rechnen fest damit, dass es auf der Sitzung am 12. und 13. Juni zu einer weiteren Erhöhung

kommen wird.

Der Dollar und die Rohstoffe steigen seit mehr als einem Jahr und verteuern die industriellen Produktions-Kosten überproportional,

weil generell weltweit die Rohstoffe an den Börsen in Dollar fakturiert (abgerechnet) werden.

Durch die gleichzeitige relative Schwäche des Euro gegenüber dem Dollar, entsteht hier eine doppelte Kosten-Belastung der

produzierenden Industrie, die einerseits durch den schwachen Euro an Marge-und andererseits durch die

hohen Importkosten der Rohstoffe an Produktivität verlieren.

Diese sich selbst verstärkenden Effekte werden auch auf die Endverbraucher Auswirkungen haben und die inflationären

Tendenzen im Euroraum verstärken und die Energiekosten stark steigen lassen.

Die Zeit der wirtschaftlichen Stabilität im Währungsraum des Euro geht langsam dem Ende entgegen, die u.a. auch durch die

protektionistische US-Handelspolitik an ihre Grenzen kommt.

Atacama-Hochland Rohstoffreiche (u.a. Lithium) Halbwüste in Südamerika

Standort vieler Teleskope bzw. Laser gestützter astro-und geophysikalischer Ortung

Dienstag, 15.05.2018

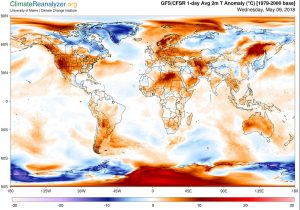

Starke Eisschmelze am Nordpol

Temperaturanomalien rund um den Nordpol. In weiten Teilen der Erde ist es verglichen mit dem langjährigen Mittel zu warm.

Besonders ausgeprägt ist die Abweichung in der Arktis und Antarktis, während es in Grönland für die Jahreszeit zu kalt ist.

Die Karte zeigt keine absoluten Temperaturen, sondern den Unterschied zum Durchschnitt.

Die aktuellen Werte rund um Spitzbergen und weiter nördlich liegen um den Nullpunkt.

Das Eis am Nordpol schmilzt im Moment wieder rapide dahin. Eine außergewöhnliche Wärmewelle treibt die Temperaturen

in der Arktis deutlich nach oben.

Die Arktis verändert sich rapide- und zum neuen Normalzustand gehören anscheinend auch regelmäßig wiederkehrende

Hitzewellen.

Seit Anfang Mai hat der Zustrom warmer Luftmassen die Temperaturen in weiten Teilen der Region in bislang noch nicht

gemessene Rekordhöhen für die Jahreszeit getrieben, wie die Washington Post berichtet hat.

Rund um den Nordpol ist es demzufolge 17 °C bis 19 ° C wärmer als im langjährigen Durchschnitt, wie auch die Daten der

dänischen Wetterbehörde es nachvollziehbar darstellen. Statt eisiger Kälte herrscht in vielen Gebieten Tauwetter,

was den ohnehin schwächelnden Meereis stark zusetzen wird.

Noch nie, seit Beginn moderner Aufzeichnungen im Jahr 1958 lagen die Werte so hoch wie dieses Jahr,

so die Meteorologen.

Rund um Spitzbergen liegt die Meereisbedeckung, lt. dem norwegischen Meereisdienst um fast 120.000 Quadratkilometer

unter dem Mittel der letzten Jahrzehnte.

Überdurchschnittlich warme und feuchte Bedingungen begünstigen die Schmelze bis weit in den Herbst hinein,

wie eine Studie aus dem „Journal of Geophysical Research“ nahelegt. Die Wärmezufuhr über dem Nordatlantik nach Spitzbergen

und darüber hinaus hat die Luftmassen allerdings nur regional verdrängt- nach Grönland, wo es für die Jahreszeit zu kühl ist.

Die Wetteraufzeichnungen der Summit Station an einem der höchsten Punkte des grönländischen Eisschildes, notierten minus

44 ° Celsius, was nur ein wenig über dem bisher tiefsten Mairekord lag. Der extreme Kontrast zwischen beiden Bereichen

der Arktis heizt gegenwärtig die Wetterküche über dem kanadischen Archipel in der Arktis an, wo es die letzten Tage stark stürmte.

Äonen im Kontext der Menschen

Rachmaninoff-Kontemplation

Montag, 07.05.2018

Forderung des BDEW: Konsequenter Ausbaupfad für KWK-Technologie

Der Bundesverband der Energie und Wasserwirtschaft (BDEW) hat Sorge, dass die konventionellen Erzeugungskapazitäten in Deutschland in absehbarer Zeit nicht mehr ausreichen, um die Stromerzeugung künftig auch in den Momenten zu sichern, wenn kein Wind weht, keine Sonne scheint und die Erneuerbaren nicht genügend Energie liefern.

Derzeit gebe es in Deutschland nur 52 Neubauprojekte für Kraftwerke mit einer Erzeugungsleistung von mehr als 20 MW- nur 14 der geplanten Anlagen seien dabei tatsächlich in Bau, hat der Verband in seiner vorgelegten Analyse zum Kraftwerkspark errechnet.

Der Trend zum Abbau gesicherter Erzeugungskapazitäten setze sich unvermindert fort. Immer mehr Gas-und Kohlekraftwerke, die jederzeit

und wetterunabhängig Strom erzeugen können, gingen demnach vom Netz, weil sie altersbedingt stillgelegt werden oder ihr Betrieb unwirtschaftlich geworden ist. Entsprechend sinke die zur Verfügung stehende gesicherte Leistung, bemängelte in Hannover Stefan Kapferer , Vorsitzender der BDEW-Hauptgeschäftsführung.

Dem bis 2023 zu erwartenden Zubau an konventioneller Kraftwerkskapazität in Höhe von etwa 4.400 MW stünden bereits absehbare und erfolgte Stilllegungen von rund 18.600 MW gegenüber, das bedeute letztlich ein sattes Minus. Damit sinke die konventionelle Kraftwerkskapazität von heute knapp 90.000 MW auf 75.300 MW. Die Bundesnetzagentur gehe aber von Anfang der 2020er Jahre von einer Jahreshöchstlast von 81.800 MW aus.

„Wir werden nicht umhin kommen, auch unkonventionelle neue Kraftwerke zuzubauen, die auch die entsprechende Grundlasteffizienz haben“.

Daher lautet der dringende Appell an die Bundesregierung, Planungssicherheit für Investoren und ein Marktdesign für gesicherte Leistung zu schaffen.

Die deutsche Energiewende verliert ihren Risikopuffer!

Die Bundesregierung sei durch europäische Vorgaben verpflichtet, ihre Klimaschutzziele bis 2030 zu erreichen!

Landschaften

Montag, 23.04.2018

Die Roboter-Dichte nimmt zu-weltweit und in Hannover

Die Automatisierung der Produktion gewinnt weltweit an Fahrt und legt gewaltig an Tempo zu.

Ablesen lässt sich das an der regelmäßig von der International Federation of Robotics (IFR) berechnet-und veröffentlichten

Statistik, die heute zu Beginn der Weltleitmesse Industrie in Hannover bekannt wurde.

Die jüngsten IFR-Zahlen besagen, das aktuell 74 Robotereinheiten pro 10.000 Angestellten produzieren, 2016 waren es

66 Einheiten.

Die fünf am stärksten automatisierten Staaten sind lt. IFR-Statistik Südkorea, Singapur, Deutschland, Japan und Schweden-in dieser Reihenfolge. Es folgen Dänemark. die USA, Italien, Belgien und Taiwan.

Das aktuell stärkste Wachstum verzeichnet die Robotik-Industrie in China, das insgesamt aber noch auf Platz 23 der Roboter-

Dichte liegt, was bei 1,4 Mrd. Bewohnern naheliegend- und somit nicht besonders aussagekräftig ist.

Bis 2020 werden weltweit mehr als 1,7 Mio. neue Industrieroboter in den Fabriken installiert, so die IFR-Prognose.

In Deutschland erwartet die Branche ein Wachstum von 5 Prozent. In den Top 10 der ausstellenden Roboterhersteller dominieren

japanische Firmen. Mit KUKA zählt allerdings auch ein deutsch-chinesisches Unternehmen dazu, dass erst vor kurzer Zeit

von den Chinesen übernommen worden ist.

In Halle 11 und 17 dominieren weitere Robotik Größen wie ABB und Kawasaki, auf dem ´Rest´ des Messegeländes und in den

Fachforen nimmt die Dichte von Industrierobotern, Cobots, autonomen Systemen oder Drohnen von Jahr zu Jahr zu.

Der Robotik-Schwerpunkt liegt weiterhin in Halle 17 , wo mobile Systeme gemeinsam mit intelligenten Kameras, Bildverarbeitungssystemen und anderen innovativen Lösungen u.a. im Application Park Robotics, Automation & Vision,

Rethink Robotics und Exoskelett-Hersteller German Bionic Systems in Aktion treten.

Robotic I

Robotic II

Wie baut man (zügig) ein Brennstoffzellen-Kraftwerk—in Asien

Montag, 09.04.2018

Die Welt wird ärmer

Die Natur erbringt jedes Jahr `Dienstleistungen` im Wert von mehreren Billionen Euro. Doch ihre Kraft schwindet dramatisch.

Wir leben mehr denn je von der Substanz.

Die Welt ist dabei , den Zauber ihrer Vielfalt zu verlieren. Viele gerade wohlhabende Staaten leben weit über ihre Verhältnisse

und damit letztlich auf Kosten anderer. Nur noch ein Viertel aller Landflächen ist unberührt, überall auf der Welt geht die

Biodiversität zurück und die Natur ist immer weniger in der Lage, die Funktionen im Leben der Menschen zu erfüllen,

auf die diese sich zunehmend gedankenlos- verlassen. Wahrlich, es ist kein freundliches Bild, das die Forscher da zeichnen,

sondern ein ziemlich düsteres, mit bedrückenden und höchstens einer leicht rosa gefärbten Hoffnung.

Die schonungslose Analyse stammt vom internationalen Wissenschaftlergremium IPBS, dem Weltrat für Biodiversität und Ökosystem-Dienstleistungen.

In Deutschland ist diese Organisation mit 129 Mitgliedstaaten relativ unbekannt, dafür im englischsprachigen Raum mittlerweile

eine Größe, die Kompetenz, wissenschaftliche Expertise- und Vertrauen in ihre Ergebnisse ausstrahlt.

Der Weltklimarat IPPC, der ähnlich strukturiert- und wesentlich älter ist, hat kürzlich festgestellt, dass es sinnvoll wäre

hier eine gemeinsame Plattform aufzustellen.

Fünf Berichte wurden vom IPBS vorgestellt, einer davon behandelt die Degeneration und den Verlust von ertragfähigen Landflächen,

die ausgelaugt werden oder sogar zu Wüsten verkommen. Die vier anderen widmen sich den Regionen Europa und Zentralasien,

Asien und Pazifik, den Amerikas sowie Afrika und analysieren dort den Zustand der Umwelt. Die wachsende Bevölkerung,

der (noch) zunehmende

Wohlstand, Monokulturen in der Landwirtschaft und der Verlust von traditionellen Wissen, setzen besonders der

biologischen Vielfalt stark zu. Der Klimawandel wiederum verstärkt die anderen Einflussfaktoren und wird teilweise selbst

von ihnen angetrieben.

Die immer noch stark steigenden Geburtenraten im Nahen-und mittleren Osten, Afrika, Mittel-und Südamerika und auf dem

indischen Subkontinent verschärfen die Situation dementsprechend weiter und werden von derzeit ca. 7 Mrd. Menschen

in den 2030er Jahren auf fast 10 Mrd. ansteigen.

Dienstleistung der Natur

Alle diese Prozesse nagen am Reichtum, den die Natur bereitstellt. Ihre Dienstleistungen sind zum Beispiel in Amerika 24

Billionen US-Dollar (19 Billionen €) pro Jahr wert-das entspricht lt. IPBS dem konventionell ermittelten Wirtschaftsprodukt

der Region.

In Europa beträgt die Angabe, dass schon Teile des Ökosystems 10.8 Billionen pro Jahr wert sind, allerdings ist die Belastbarkeit

der Ergebnisse und Summe umstritten.

Trotz seines natürlichen Wohlstandes führt Europa so viel Nahrungs- und Futtermittel ein, dass es eine zusätzliche Fläche

in der Größe Deutschlands bräuchte um alles selbst zu produzieren. Diese Felder, Wälder und Weiden liegen jedoch auf anderen Kontinenten.

Wald stirbt für Fleisch und Ackerflächen

Brasilien gehört ebenfalls zu den Ländern, die Ackerflächen für die Bedürfnisse der reichen Länder zur Verfügung stellen,

genauso wie es in Teilen von Afrika für die Chinesen geschieht, wobei die meisten Afrikaner keinen anderen Ausweg aus

ihrer Armut sehen.

Dort werden aktuell riesige Landflächen von großen Staatsbetrieben aufgekauft und in landwirtschaftliche Nutzflächen,

ohne die geringsten Ökostandards einzuhalten, umgewandelt.

Solche Abholzung und Umnutzung ist oft der erste Schritt zu einer Degeneration und dem eventuellen Verlust von Landflächen,

stellt der fünfte der neuen Berichte fest. 1.5 Milliarden Hektar natürliches Ökosystem (410-mal die Fläche Deutschlands) waren

bis 2014 bereits in Agrarflächen umgewandelt worden. Nur 25 Prozent der Erdoberfläche sind unberührt, und der Prozess

geht beschleunigt weiter: 2050 dürften es bloß noch zehn Prozent sein, schätzen die Wissenschaftler.

Die Menschheit legt die Kettensäge an den Baum des Lebens, die Ausrottung von Arten tritt nun offiziell neben den

Klimawandel als große Gefahr für die Zukunft.

Alles ist mit Allem verbunden; es gibt kein Nichts

Energiefelder mit korrespondierenden Elementarteilchen waren die ersten Bausteine unserer Existenz

Montag, 26.03.2018

Neues Bundes-Förderprogram Modellvorhaben Innovative Wärmenetzsysteme 4.0

Projektträger: Bundesanstalt für Wirtschaft und Ausfuhrkontrolle Bafa in Eschborn

Mit der systemischen Förderung „Modellvorhaben Wärmenetzsysteme 4.0“ werden nicht nur Einzeltechnologien

und Komponenten, sondern auch Gesamtsysteme gefördert, die insbesondere u.a. auch im Bereich der Wärmeinfrastruktur eingeführt bzw. integriert werden sollen.

Priorität soll die effiziente Nutzung der Abwärme von Energieerzeugungs-Anlagen und vielfältigen anderen Systemen haben, die noch keine entsprechende Nutzung der anfallenden Wärmeenergie haben.

Gefördert werden zunächst Machbarkeitsstudien mit bis zu 60 Prozent der förderfähigen Kosten, sowie in einem zweiten Schritt die Realisierung eines Wärmenetzsystems 4.0 mit bis zu 50 Prozent der förderfähigen Kosten des Vorhabens.

Die Höhe der Förderung beträgt dabei bis zu 600.000 € für Machbarkeitsstudien und bis zu 15 Mio. € für die Realisierung des Wärmenetzsystems 4.0 .

Ergänzend können zudem Maßnahmen zur Kundeninformation im Gebiet des geplanten Wärmenetzsystems 4.0

zur Erhöhung der Anschlussquote an ein Modellvorhaben mit bis zu 80 % der förderfähigen Kosten und bis zu einer betragsmäßigen Obergrenze von max. 200.000 € als Zuschuss gewährt werden.

Projektbezogene wissenschaftliche Kooperationen mit Hochschulen, Forschungs-und Wissenschaftseinrichtungen zur Unterstützung, Planung, Realisierung und Optimierung sowie Evaluation eines Wärmenetzsystems 4.0 können bis zu einer Obergrenze von 1 Mio. € als Zuschuss gewährt werden.

Für Beratung und weiterführende Informationen stehen wir Ihnen selbstverständlich zur Verfügung und—

wir haben die Expertise die vorgenannten Anforderungsprofile umzusetzen.

Montag, 19.03.2018

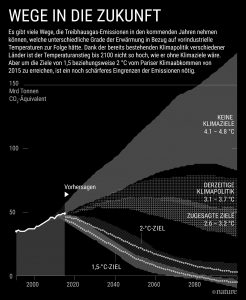

Nationale Egoismen sorgen für ein Scheitern der aktuell gültigen Vereinbarung von Klimaschutzmaßnahmen

Selbst bei einer jährlichen Reduktion der Emissionen von drei Prozent sind die Vorgaben des Weltklimarates IPPC bis 2030 nicht mehr zu erreichen.

Die aktuelle Vereinbarung der Staaten sieht derzeit nur einen Rückgang der Emissionen von 1.5 Prozent jährlich vor und verursacht höchstwahrscheinlich

ein fast komplettes Abschmelzen, nicht nur der Arktis und auf Grönland- sondern auch eines relativ großen Teils der Antarktis.

In einem Sonderbericht, der im Herbst erscheinen soll, will der Weltklimarat die Gemeinschaft der Staaten aufrütteln und zumindest eine Verdopplung

der aktuellen Klimavereinbarung auf drei Prozent erreichen.

Beispielsweise könnte schon ein kleiner Energieboom in der Arktis, der nicht nur von Trump, sondern auch von der russischen Förderation bereits

vorbereitet wird, ein massives weiteres Abschmelzen der Eismassen beschleunigen.

Die Polarregionen werden durch das frühere Schmelzen der Eismassen besser zugänglich und könnten die, auch dort vermuteten Vorräte von Öl und

Gas bald zur Ausbeutung erschließen.

Die Klimawissenschaftlerin Katherine Hayhoe von der University of Texas in Lubbock und Mark Lawrence vom Institut für transformative

Nachhaltigkeitsforschung (IASS) in Potsdam, kommen in diesem Zusammenhang auf fast die gleiche Deadline.

Anfang der 2020er Jahre vergeht jede Chance, die bisher vereinbarten Klimaziele, die derzeit größtenteils faktisch nicht eingehalten werden,

selbst auf die aktuell gültigen 1.5 % zu begrenzen.

Klimatisch-apokalyptisch anmutende Zustände, die unsere Kinder letztendlich irgendwie bewältigen müssen, können derzeit nicht mehr ausgeschlossen

werden.

Donnerstag, 15.03.2018

Energiewende: Deutschland im europäischen Vergleich abgehängt-und auf Platz 16

Der Energiewende-Index vom World Economic Forum und der Unternehmensberatung McKinsey als

sogenannter Transition Index ETI vorgestellt, vergleicht anhand von 40 Kriterien den Fortschritt der Energiewende in 114 Ländern.

Die Ergebnisse wurden gestern beim Weltwirtschaftsforum in Sao Paulo bekannt und stellten den ehemaligen Vorreiter

der Energiewende ins Abseits.

Deutschland hat trotz wirtschaftlicher Stabilität sein Klimaziel, den CO2-Ausstoß bis 2020 im Vergleich zu 1990 um 40 % zu reduzieren

eindeutig verfehlt. Der Emissionsausstoß stagniert seit Jahren auf hohem Niveau.

So konnte die Bundesrepublik ihre Pro-Kopf- Emissionen in den vergangenen zehn Jahren nur um 6.5 % minimieren.

Dies spiegelt sich in der Kategorie „Umwelt-und Klimaschutz“ in Form von Platz 61 wieder,der CO2-Ausstoß in Deutschland

liegt seit 2014 auf unverändert hohen Niveau. Verantwortlich dafür ist u.a. die Abhängigkeit vom Kohlestrom, die Alternativen

zur Kohleverstromung, die seit Jahren nicht nur bei uns vorhanden sind, werden größtenteils immer noch von der starken

Energielobby in der Politik blockiert.

Länder wie Dänemark und Großbritannien kommen mittlerweile ohne fossile Brennstoffe aus.

Großbritannien ist z.B. auf einen Kapazitätsmarkt für Strom umgestiegen und erhält damit flexible Kraftwerke, gleichzeitig hat das

Land einen CO2-Mindestpreis eingeführt, der deutlich über dem Zertifikatspreis im europäischen Emissionshandel liegt.

Die hohen Strompreise in Deutschland für Privathaushalte und kleinere Industriekunden (große Industriekunden erhalten Sonderverträge oder sind eigene Energieerzeuger) sorgen dafür, dass die Bundesrepublik auf Platz 44 landet, damit schnitten

sogar die Slowakei, Paraguay und Indonesien besser ab.

Deutsche Privathaushalte zahlen aktuell 30,8 ct/kWh und damit 46,6 Prozent mehr als ihre europäischen Nachbarn.

Industriestrompreise stiegen zuletzt in Deutschland um 0,7 % während in Europa die Preise um 0,5 Prozent sanken. Das hiesige Preisniveau von 9,72 ct/kWh liegt nun 14,8 Prozent über dem europäischen Durchschnitt, in der Versorgungssicherheit liegt Deutschland

mittlerweile auf Platz 14-.

Die Hoffnung stirbt zuletzt, allerdings hat Berlin jetzt „Prioritäre Nachhilfe“ von der EU-Kommission bekommen und von derselben

Strafandrohungen von mehreren Hundert Mio. € erhalten,wenn die Klimaziele nicht eingehalten werden.

Resultat: Es sollen neue Fördermaßnahmen aufgelegt werden, die Deutschland wieder in die erste Reihe bringen u.a. auch eine starke

Förderung innovativer Technologien und Anwendungen.

Montag, 05.03.2018

Industrie-Messe Hannover 23.04.-27.04.2018

Hype 2018 Machine Learning-Künstliche Intelligenz- Industrie 4.0

Maschinelles Lernen ermöglicht es, anhand großer Datenmengen Vorhersagen zu treffen.

Das Teilgebiet von Artificial Intelligence basiert auf Mustererkennung und besitzt die Fähigkeit, selbständig Wissen aus

Erfahrungen zu erzeugen.

Damit findet die Technologie ihren Einsatz in industriellen Prozessen- und schon seit längerem auch bei uns in der

Betriebsführung unserer Energie-Erzeugungsanlagen!

Künstliche Intelligenz ist keine Zukunftsvision mehr. Große Rechenzentren und enorme Speicherkapazitäten ermöglichen heute,

was man jahrelang in weiter Ferne glaubte.

Die Teildisziplinen Machine Learning und Deep Learning nutzen die Möglichkeiten von Big Data, um Prozesse zu optimieren,

neue Lösungen zu finden und Erkenntnisse zu gewinnen.

Wie fast immer bilden auch hier Algorithmen die Basis

Ob großer Weltkonzern oder mittelständisches Unternehmen- in jeder Firma fallen Daten an, auf die man zurück greifen kann.

Mit Hilfe von Software werden diese zusammengeführt, ausgewertet und schließlich Vorhersagen getroffen. Maschinelles Lernen

erkennt Merkmale, Beziehungen und leitet daraus auf Basis von Algorithmen Verallgemeinerungen ab.

Big Data für die Prozessoptimierung

Richtig analysiert können mit der Hilfe von Kunden-, Log-und Sensordaten neue Lösungen gefunden- und z.B. Prozesse

effizienter gemacht werden.

Benötigt wird neben Massen an Daten eine IT-Infrastruktur, die auf Artificial-Intelligence-Verfahren und Machine-Learning-

Workloads eingestellt ist. Die genauen Aufgaben der ML-Systeme sind exakt und klar festgelegt.

Muster erkennen und daraus Rückschlüsse ziehen, das Gelernte können sie dann weiter anwenden.

Aktuelle Anwendungsbereiche von ML

Das am häufigsten verwendete Lernverfahren ist aktuell die Bilderkennung. Weitere Anwendungsbereiche sind digitale Assistenten bzw. intelligente Bots, Gesichtserkennung, Spracherkennung und Sprachverarbeitung, automatisierte Übersetzung und

Transkription, Text-und Videoanalyse sowie autonomes Fahren.

Künstliche Intelligenz in der Industrie 4.0

In der Smart Factory sind die Produktionsprozesse vernetzt, Maschinen, Schnittstellen und Bauteile kommunizieren miteinander.

Zahlreiche Daten können erhoben und so der Fertigungsablauf optimiert werden. Big Data unterstützt beispielsweiser bei der Prozessoptimierung, indem Bildanalyse und Bilderkennung eingesetzt werden.

Digitale Überwachung und Steuerung

In den Fertigungshallen identifizieren intelligente Systeme Objekte auf Förderbändern und können diese automatisch sortieren.

Solche Systeme finden ihren Einsatz auch im Rahmen der Qualitätskontrolle; sie erkennen ob ein Produkt fehlerhaft ist, also z.B.

falsch eingefärbt wurde.

Artificial Intelligence und Predictive Maintenance

Auch im Bereich Wartungs- und Supportdienstleistungen setzen Unternehmen heute Machine Learning ein.

Artificial Intelligence hilft dann dabei, mittels Sensoren den Energieverbrauch der einzelnen Maschinen zu erfassen, Wartungszyklen zu

analysieren und im zweiten Schritt zu optimieren. Die Betriebsdaten geben Aufschluss darüber, wann ein Teil ausgetauscht werden muss oder ein Defekt wahrscheinlich ist. Je mehr Daten vorliegen, desto besser kann sich das System selbst optimieren und immer genauere Vorhersagen treffen.

Wachstumsschub durch künstliche Intelligenz erwartet

Unternehmen die auf Machine-Learning Verfahren setzen, steigern ihre Wirtschaftsleistung, so die Meinung von Experten,

die größten Zuwächse werden in der IT- und Finanzbranche, im Bereich Telekommunikation und im produzierenden Gewerbe erwartet.

Freitag, 16.02.2018

Zellstrukturen Neuronen

Wie der Motor des Klimawandels unsere Nahrungskette beeinflusst

Die Anreicherung von Kohlendioxid lässt manche Seen und Teiche, generell alle Süßwassersysteme, schneller versauern als z.B. Ozeane.

Beim Klimawandel war es lange wie mit den Bienen oder Schmetterlingen, was heraussticht wird beachtet.

Meere, Gletscher, Zyklone, nach der empirischen Unterfütterung der Erderwärmung war an diesen Teilsystemen alles interessant,

wurden riesige Messkampagnen gestartet, um den Wandel zu dokumentieren, und komplexe numerische Modelle entwickelt.

Das System besteht aber nicht nur aus groben Klötzen, es sind auch die kleineren Teile des Erdsystems die am Klimawandel mitwirken-

oder selbst zum Opfer werden.

Die fruchtbaren Böden gehören genauso dazu, aber ebenso die unzähligen Wasserreservoire- Seen, Teiche und Tümpel-, die sowohl als

Wasserspeicher wie als Lebensraum und Fischgründe die Kontinente überzieht.

Hat der Klimawandel hier schon Spuren hinterlassen?

Vor wenigen Wochen haben Forscher der ETH Zürich zusammen mit kanadischen Kollegen eine klimatologische Antwort gegeben.

Mit einer Wahrscheinlichkeit von mehr als neunzig Prozent schlägt sich der anthropogene Klimawandel in den Gewässern Europas bereits nieder.

Und zwar nicht in der Temperatur, sondern in einem hydrologischen Signal, das zumindest für die Jahre zwischen 1956

und 2005 statistisch eindeutig ist. Im Norden Europas, so schreiben die Autoren in „Nature Climate Change“, nehmen die Wassermengen zu, auch die Niederschläge;

rund ums Mittelmeer wird es zunehmend trockener, das ist keine Überraschung.

Die Befunde lassen sich gut mit den Ergebnissen einer neuen Modellier-Studie aus dem Potsdam-Institut für Klimafolgenforschung

(„Science Advances“) in Einklang bringen, in der die weltweiten Hochwasserrisiken prognostiziert werden.

Überrascht hat jedoch eine Untersuchung von Wissenschaftlern der Ruhr-Universität in Bochum. Linda Weiss und Ralph Tollrian

haben mit Kollegen das Phänomen Versauerung untersucht.

Welche Gefahren für die Meeresökosysteme der fortgesetzte Eintrag des Treibhausgases Kohlendioxid ins Wasser und seine Umwandlung

in Kohlensäure insbesondere für Fisch-und Korallenbestände haben könnte, wird seit Jahren intensiv erforscht.

Um 0,3 bis 0,5 Einheiten auf der pH-Skala könnte der Säurewert der Ozeane bis zum Ende des Jahrhunderts steigen,

prognostizieren Ozeanographen.

Das klingt auf den ersten Blick nach nicht viel. Wegen der logarithmischen pH-Skala steckt dahinter aber eine starke Versauerung,

die genauso gewaltige Veränderungen im Ökosystem nach sich ziehen kann-ein beschleunigtes Korallensterben etwa, was bereits

weltweit im Gange ist.

Wie sich der sukzessive Eintrag freilich auf die Süßgewässer auswirkt, blieb bisher unklar.

Die Bochumer Forscher haben jetzt in der Zeitschrift “ Current Biology“ gezeigt:

Seen und Teiche könnten, sofern sie nicht durch Kalkgestein am Grund abgepuffert werden, noch schneller versauern.

Die Wissenschaftler haben vier deutsche Wasserreservoire mit entsprechend langen- 35-jährigen Datenreihen im Ruhrverband

untersucht (Möhne, Lister, Henne und Sorpe) weswegen sich Verallgemeinerungen verbieten.

Aber dort zumindest schreitet die Versauerung doppelt so schnell voran wie in den Meeren: im Schnitt um 0,01 pH pro Jahr.

In Testreihen mit steigenden Gehalten an Kohlendioxid im Wasser und entsprechend saurerem Milieu reagieren zum Beispiel

Kleinkrebse, die Nahrungsgrundlage ganzer Süßwassergemeinschaften sind, erstaunlich schnell und deutlich.

Das Mehr an Kohlendioxid im Wasser verursacht neurologische Defekte an den Antennen der Tiere, die letztlich ihre Fressfeinde

nicht mehr wahrnehmen und somit als Futterquelle der gesamten Süßwassergemeinschaften ausfallen.

Mittwoch, 31.01.2018

Krebszelle DNA

Immer mehr Mikroplastik- nicht nur in den Weltmeeren- auch im Trinkwasser in Deutschland

Zwischenergebnisse des Bundesumweltamtes lassen aufhorchen. Plastikartikel im Wasser werden von Zellen aufgenommen,

reichern sich an und stören die Kommunikation derselben.

Im Umweltbundesamt (UBA) im vogtländischen Bad Elster werden aktuell Versuchsreihen ausgewertet, die im Ansatz darauf hindeuten, dass in

Zellkulturen, die den menschlichen sehr nahe sind, Störungen auftauchen.

„Wir konnten nachweisen. dass die vorgenannten Partikel in den Zellen aufgenommen werden, sich dazwischen anreichern und letztendlich die

Kommunikation stören“, sagt die Abteilungsleiterin Dr. Tamara Grummt.

Am Ende will das sechsköpfige Team eine fundierte Einschätzung liefern, ob Mikroplastik eine Gesundheitsgefahr ist.

Die gestörte Kommunikation zwischen den Zellen und Entzündungsreaktionen deuten darauf hin, sagt Dr. Grummt.

„Das Trinkwasser hat sich zwar im Verlauf der Jahre nicht wesentlich verschlechtert, aber es kommen neue Spurenstoffe hinzu, wie Arzneimittelreste

oder eben auch Mikroplastik, die wir bewerten müssen“.

Erste Proben aus deutschen Gewässern zeigten diesbezügliche Spuren.

Das aktuelle Verbundprojekt „Mikroplastik im Wasserkreislauf (MiWa), mit Partnern aus ganz Deutschland ist ein wichtiger Schritt um

belastbare Ergebnisse zu erzielen.

Die Expertise der beteiligten Institutionen, wie Wasserbetriebe, Forschungseinrichtungen und die Förderung durch das Bundesministerium

für Bildung und Forschung (BMBF) deutet darauf hin, dass hier ernsthafte Probleme entstehen, die wegen des Eintrages von Mikroplastik und

anderen Schadstoffen in unseren Gewässern, die Gesundheit der Menschen immer mehr belastet.

Im Jahr 2050 wird es mehr Plastik im Meer geben als Fische !

Mittwoch, 24.01.2018 Studie: “ Der E-Mobilitäts-Blackout“

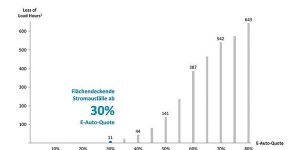

„Das Niederspannungsnetz kann künftig die Zahl an E-Fahrzeug nicht mehr bewältigen“, warnt die Studie.

„Im Jahr 2035 wird voraussichtlich mehr als jedes dritte Auto auf deutschen Straßen ein E-Auto sein“.

In Stadtrandlagen mit hoher Affinität der Bevölkerung zur Elektromobilität soll bereits in fünf bis zehn Jahren eine

E-Auto-Quote von 30% erreicht werden und damit zu punktuellen Stromausfällen führen.

Die Autoren führen zwar aus, das die Ladezeiten sehr kurz sind und während der Nacht, also in Schwachlastzeiten

ausgeführt werden können; doch mit der aktuell verfügbaren Technik dauern die Ladevorgänge an einer Haushaltsteckdose

mehr als 12 Stunden und könnten aus Sicht der Autoren, nur mit einer intelligenten Softwarelösung variabel zeitversetzt beseitigt werden.

Doch die Problematik der Netzüberlastung durch die E-Mobilität ist wesentlich weiter gefächert!

Physikalisch sind die kW-Übertragungs-Kapazitäten im Niederspannungsnetz begrenzt und können letztlich nur durch Ladespots im Mittelspannungsnetz, oder durch eigene Erzeugungskapazitäten ausgeglichen werden.

Zum Beispiel Stadtwerke mit E-Bussen, Unternehmen und andere E-Flottenbetreiber können die Lade-Kapazitäten nur erreichen, indem sie die vorgenannten eigenen Erzeugungskapazitäten aufbauen, oder mit entsprechenden Transformatoren an der Hoch-bzw. Mittelspannung individuell ergänzen.

Allerdings werden auch in diesem Bereich die Übertragungs-und Kapazitätsengpässe (Dispatch, Redispatch) in der Hochspannung immer häufiger, die sich letztendlich durch den mangelnden und verzögerten Ausbau der Netzstrukturen noch weiter verstärken werden.

Donnerstag, 18.01.2018

Neue BDI-Studie

Investitionsturbo für den Klimaschutz

Dunkel gezeichnete Gebiete potentiell durch Überflutung gefährdet

Die vom Bund der deutschen Industrie in Auftrag gegebene Studie wurde von der Boston Consulting Group und Prognos erstellt und postuliert einige Thesen, die dieselben auf der Basis der 1990 erstellten Treibgasreduktion-Vorgabe, bis 2050 mit 80% als erreichbar definiert.

Zwingende Vorrausetzung sind massive technologieoffene ökonomisch sinnvolle Investitionen in bereits vorhandene Technik und logischerweise aus BDI-Sicht, die Befreiung energieintensiver Unternehmen von klimapolitisch bedingten Zusatzlasten.

Ein 80-Prozent-Ziel wäre aus BDI-Sicht sogar im nationalen Alleingang ohne Wachstumseinbußen, also mit der vielzitierten schwarzen Null, möglich.

Zu diesem Ergebnis kommt die Studie „Klimapfade für Deutschland“, die der BDI auf einem Klimakongress am Donnerstag

in Berlin vorstellte.

Den Berechnungen zufolge erfordert die Erreichung eines 80-Prozent-Klimaziels Mehrinvestitionen von etwa 1,5 Billionen €

bis 2050.

Eine 95-prozentige Treibhausgas-Reduktion dagegen würde nach heutigem Stand, an erhebliche Akzeptanz-und Umsetzungsgrenzen stoßen und wäre nicht realistisch erreichbar.

Sie wäre erst dann vorstellbar , wenn es global in allen wichtigen Wirtschaftsräumen vergleichbare Klimaschutzanstrengungen

gäbe.

„Politische Fehlsteuerung bleibt für den Klimaschutz das größte Umsetzungsrisiko“, warnt BDI-Präsident Dieter Kempf.

Unflexible Sektorziele, Technologieverbote, beispielsweise von Verbrennungsmotoren, oder planwirtschaftliche Instrumente

wie eine E-Auto-Quote sind nach seiner Meinung der falsche Weg.

Ob Wohnen oder Verkehr, ob Industrie oder Landwirtschaft:

Investitionen kommen nicht von alleine.

„Die deutsche Klimaschutzpolitik droht auf eine drastische Erfüllungslücke zuzusteuern“.

„Die deutsche Klimaschutz-und Energiepolitik befindet sich auf gefährlichem Schlingerkurs, den muss die Politik dringend

korrigieren“, kritisiert Kempf.

„Nach wie vor viel zu hohe Stromkosten, das Schneckentempo bei der energetischen Gebäudesanierung und eine fehlende gemeinsame Vision der zukünftigen Mobilität, beunruhigen die deutsche Industrie“, warnt der BDI-Präsident.

Die Studie verdeutlicht das enorme Potenzial disruptiver Innovationen.

Dazu gehören etwa Technologiedurchbrüche in der Wasserstoff-Wirtschaft oder beim Carbon-Capture-and Use-Verfahren.

Wir brauchen eine technologieoffene Forschung- und auch Anwendung bereits vorhandener Verfahren und last but not least

die dringend notwendige und derzeit nicht vorhandene Unterstützung durch die Politik.

Bonmot

Errare Humanum est

Irrtum ist menschlich,

im Irrtum beharren ist

dumm!

„Beharrungstendenz der

Meinungssysteme“!

Donnerstag, 11.01.2018

Klimaschutz

Ökostrom-Förderung größtenteils Ineffizient

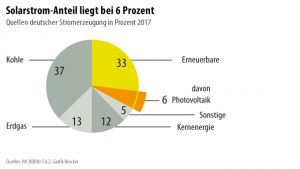

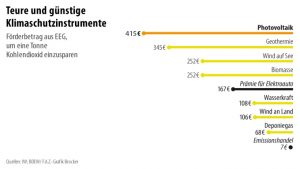

Der Anteil erneuerbarer Energie an der deutschen Stromerzeugung hat einen neuen Rekordwert erreicht.

Jede dritte Kilowattstunde stammt aus einer Wind-, Solar-oder Biogasanlage.

Zugleich steigen die Ausgaben zur Förderung des Ökostroms, wobei sich Photovoltaik als besonders ineffizient erweist.

Nach den Daten der Bundesnetzagentur wurde 2016 aus Windkraftwerken an Land (Onshore) doppelt so viel Strom eingespeist

wie aus Solaranlagen.

Dennoch kassierten deren Betreiber mit 10,2 Mrd. € mehr als das Doppelte dessen was Windmüller bekamen; es waren 4,7 Mrd.€-.

Das Institut der deutschen Wirtschaft Köln (IW) hat sich mit der klimapolitischen Effizienz einzelner Technologien näher befasst.

Auch hier lautet das Ergebnis:

Die Förderung von Photovoltaik nach dem EEG ist die teuerste Strategie zur Vermeidung von CO2 !

Der notwendige Nord-Süd Netzausbau, der prioritär für den Transport von Offshore-Windstrom nach Baden-Württemberg

und Bayern wegen der Abschaltung aller AKW`s bis 2022 unverzichtbar ist, macht den Windstrom noch ineffizienter

als die Photovoltaik.

Daraus resultierend werden die Verbraucher in den nächsten Jahren mit permanent steigenden Netz- und

Erzeugungskosten belastet.

Viele Versorgungsunternehmen und Börsennotierte Investment-Gesellschaften haben in den letzten Jahren massiv in

Windkraftanlagen investiert und durch die garantierten hohen Einspeisevergütungen immense Gewinne gemacht.

Kraftwärme-Kopplung (KWK) mit Brennstoffzellen-Technik ist die Effizienteste Art Energie zu erzeugen und Gewinnezu realisieren.

Trotz relativ geringer Zuschüsse im Vergleich zu den EEG-Fördersätzen ist die BZKW-Technologie überproportional Rentabel

Raumzeit-Reise

Dienstag, 02.01.2018

Netz-Stabilisierung 2017 mit über 1 Mrd. € auf Rekord-Niveau

Dispatch- und Redispatch-Maßnahmen für die Netzstabilisierung kosteten vergangenes Jahr beim Verteilungsnetzbetreiber

Tennet mehr als eine Mrd. Euro, Amprion und 50Hertz, die beiden anderen Netzbetreiber, haben ihre entsprechenden

Kosten noch nicht veröffentlicht.

Der immer noch schleppend verlaufende Nord-Süd Netzausbau, das gesetzlich garantierte Einspeisen und Regulieren von

überschüssigen Offshore-Windstrom, mit daraus resultierenden negativen Börsen-Strompreisen, hat diese Kosten verursacht.

Per Saldo wird das den Verteilungsnetzbetreibern aber nicht die Bilanz verhageln, die Kosten werden über die EEG-

Umlage regelmäßig auf die Verbraucher verteilt und sorgen dafür, dass die Investoren in dieser Anlagenklasse enorm-

unanständige Renditen erwirtschaften.

KI–Thesen 2018

- Konstante Widersetzung evolutionärer Ordnungsprozesse der Entropie, die lt. Antonio Damasio (Neurologe)

im Kontext der rasanten Entwicklung künstlicher Intelligenz, zunehmend aufgelöst werden könnten.

Damasio meint: „Gleichgewicht der Affekte ist und bleibt mit KI zwar ein Balanceakt, aber unsere

biologisch-kulturellen Wurzeln werden sich auch in zukünftigen Algorithmen wieder finden“. - Der Physiker Max Tegmark denkt darüber nach, dass uns Technologie verändert, postuliert aber die

Weiterentwicklung des Homo Sapiens mit dem Begriff „Leben 3.0″ , der in seiner Deutung eine inspirierende

Zukunft kreieren kann.

“ Wir müssen den Wettlauf gewinnen zwischen der wachsenden Macht der KI und der (hoffentlich)

wachsenden Weisheit, mit der wir sie managen“. - Der Physiker Stephen Hawking meint und bekräftigt seine große Warnung,“ ich fürchte, das KI die Menschen

insgesamt ersetzen kann“; früher war er positiv utopisch, jetzt, in Bezug auf sein Alter und seine Krankheit (ALS)

kann man diese Meinung nur als ´dystopische Übertreibung´ für die Zukunft des Menschen bezeichnen. - Hinter gerade angesagten Begriffe wie Maschinellem Lernen, Deep Learning, oder künstlichen neuronalen Netzen,

stecken erstmal wesentliche Klassifizierungsprobleme und ausgeklügelte Statistiken. - Marvin Minsky, einer der KI-Vordenker nannte Intelligenz mal ein Kofferwort-jeder packt hinein,

was er gerne hören oder interpretieren möchte; er nannte es auch „Kohlenstoff-Chauvinismus“ ,

und verachtet jene arrogante Haltung, nach der Dinge nicht intelligent sein können, wenn sie

nicht auf Kohlenstoff basieren.

Aus seiner Perspektive als Physiker ist Intelligenz jedoch eine bestimmte Art der

Informationsverarbeitung, die bewerkstelligt wird von sich bewegenden Elementarteilchen.

„Es gibt kein Gesetz der Physik, das besagt, dass man nicht auch Maschinen konstruieren kann,

die in jeder Hinsicht intelligenter sind als wir“.

- Das deutet darauf hin, dass wir bisher erst die Spitze des ´Intelligenz-Eisbergs´ gesehen haben

und das es ein verblüffendes Potential gibt, die volle Intelligenz zu erschließen, die in der Natur

verborgen ist. - Der oben genannte Begriff „Leben 3.0“ bedeutet übrigens aus seiner Sicht, das diese Evolutionsstufe

vom Menschen noch lange nicht erreicht worden ist.

Leben 1.0 bezeichnet Minsky als Entwicklungsstufe von Bakterien. - Leben 2.0 ist die Stufe, die vom Menschen erreicht worden ist indem er bisher erstmal gelernt hat zu

Lernen.

Vielleicht sollte man die aktuelle menschliche Entwicklungsstufe mit Leben 2.1 skalieren.

Homo Erectus-Homo Neanderthalensis- Homo Sapiens- ´Homo Digitalis´- „Homo Cybernetics“………………………….?

Wir haben vorerst nur gelernt Maschinen zu entwerfen, die fliegen können und krankhafte physische und psychisch-

kognitive Degenerationserscheinungen durch Implantationen und sonstige Eingriffe in „unserer Hard-

und Software“, auf die eine oder andere Art zu kompensieren.

Raumzeit-Dimensionen

Dienstag, 19.12.2017

E-Mobilität

Schnelles Laden und Automatisierte Abrechnungssysteme mit Blockchain-Technologie

Die Problematik ist, dass die Nutzer mit den derzeit verfügbaren Systemen, als größte Hürde immer noch mit

langen Ladezeiten, hohen Spannungen, starken Strömen und überhitzten Kontaktwiderständen hantieren müssen.

Abhilfe kann hier der neue Standard HPC (High Power Charging) schaffen, mit dem sich eine Reichweite von

400 Kilometern in 12 Minuten laden lässt.

Mit Spannungen bis zu 1000 Volt und Strömen von bis zu 400 Ampere lässt sich die vorgenannte Reichweite

erreichen und diese sind von ihrer Stärke vergleichbar, mit dem früher ganze Straßenzüge angeschlossen wurden.

Über 400 kW Ladeleistung werden mit diesem System erreicht, was ungefähr einer Leistung von 108 Haushaltssteckdosen

entspricht.

Die Ströme in Kabel und Stecker sind (noch) so groß, dass nur mithilfe eines eigenen Kühlsystems eine Überhitzung

vermieden wird.

Verschiedene Anbieter von Ladetechnologien arbeiten auch an integrierten Abrechnungssystemen, die mittels Blockchain-

Technologie, die entsprechenden Zahlungs- und Zugriffsmodalitäten enthalten.